한글 번역은 파파고 번역이기 때문에 어색할 수 있습니다.

단어 하나하나 보다는 맥락을 이해하시면 도움이 될 것 같습니다.

Q.41

A business uses Amazon EC2 instances to execute a bespoke web application behind an Application Load Balancer. The instances are managed as part of an Auto Scaling group. The company's development team deploys all services through AWS CloudFormation. When the development team runs a new instance of the program, it takes time to install and setup.

Which sequence of actions should a developer follow to improve efficiency while launching a new instance? (Select two.)

- A. Use an AWS Marketplace Amazon Machine Image (AMI) with a prebuilt application.

- B. Create a prebuilt Amazon Machine Image (AMI) with the application installed and configured.

- C. Update the launch template resource in the CloudFormation template.

- D. Use AWS Systems Manager Run Command to install and configure the application.

- E. Use CloudFormation helper scripts to install and configure the application.

기업은 Amazon EC2 인스턴스를 사용하여 애플리케이션 로드 밸런서 뒤에서 맞춤형 웹 애플리케이션을 실행합니다. 인스턴스는 자동 스케일링 그룹의 일부로 관리됩니다. 그 회사의 개발 팀은 AWS CloudFormation을 통해 모든 서비스를 배포한다. 개발 팀이 프로그램의 새 인스턴스를 실행할 때 설치 및 설정에 시간이 걸립니다.

개발자가 새 인스턴스를 실행하는 동안 효율성을 향상시키려면 어떤 일련의 조치를 따라야 합니까? (2개 선택)

- A. 사전 빌드된 애플리케이션과 함께 AWS Marketplace AMI(Amazon 시스템 이미지)를 사용합니다.

- B. 애플리케이션을 설치하고 구성한 상태에서 사전 빌드된 AMI(Amazon 시스템 이미지)를 생성합니다.

- C. CloudFormation 템플릿에서 시작 템플릿 리소스를 업데이트합니다.

- D. AWS Systems Manager Run Command를 사용하여 응용 프로그램을 설치하고 구성합니다.

- E. CloudFormation 헬퍼 스크립트를 사용하여 응용 프로그램을 설치하고 구성합니다.

스택 및 리소스를 설정한 후에 템플릿을 재사용하여 다양한 환경에서 인프라를 복제할 수 있습니다.

CloudFormation 템플릿에서 이러한 헬퍼 스크립트를 호출하여 동일한 템플릿에 있는 Amazon EC2 인스턴스에서 애플리케이션을 설치, 구성 및 업데이트합니다.

AWS CloudFormation 모범 사례 - AWS CloudFormation

AWS CloudFormation 모범 사례 - AWS CloudFormation

이 페이지에 작업이 필요하다는 점을 알려 주셔서 감사합니다. 실망시켜 드려 죄송합니다. 잠깐 시간을 내어 설명서를 향상시킬 수 있는 방법에 대해 말씀해 주십시오.

docs.aws.amazon.com

Q.42

An API Gateway and AWS Lambda are used in a serverless application.

Where should the Lambda function's session data be stored between function calls?

- A. In an Amazon DynamoDB table

- B. In an Amazon SQS queue

- C. In the local filesystem

- D. In an SQLite session table using DSQLITE_ENABLE_SESSION

API Gateway와 AWS Lambda는 서버가 없는 응용 프로그램에서 사용됩니다.

함수 호출 사이에 람다 함수의 세션 데이터를 어디에 저장해야 합니까?

- A. Amazon DynamoDB 테이블에서

- B. Amazon SQS 대기열에서

- C. 로컬 파일 시스템에서

- D. SQLite 세션 테이블에서 DSQLITE_ENABLE_SESSION을 사용합니다.

AWS Lambda에서 실행하는 코드는 'Lambda 함수'로 업로드됩니다.

모든 지속 상태는 Amazon S3, Amazon DynamoDB, Amazon EFS 또는 다른 인터넷 사용 스토리지 서비스에 저장되어야 합니다.

AWS Lambda – FAQ

aws.amazon.com

Q.43

A Linux, Apache, MySQL, and PHP (LAMP) stack is used to construct an on-premises application. The developer want to host this application on Amazon Web Services.

Which of the following AWS service sets is appropriate for running this stack?

- A. Amazon API Gateway, Amazon S3

- B. AWS Lambda, Amazon DynamoDB

- C. Amazon EC2, Amazon Aurora

- D. Amazon Cognito, Amazon RDS

- E. Amazon ECS, Amazon EBS

Linux, Apache, MySQL, PHP(LAMP) 스택은 온프레미스 애플리케이션을 구성하는 데 사용됩니다. 개발자는 이 응용 프로그램을 Amazon Web Services에서 호스팅하려고 합니다.

다음 중 이 스택을 실행하는 데 적합한 AWS 서비스 세트는 무엇입니까?

- A. Amazon API 게이트웨이, Amazon S3

- B. AWS 람다, Amazon DynamoDB

- C. 아마존 EC2, 아마존 오로라

- D. Amazon Cognito, Amazon RDS

- E. Amazon ECS, Amazon EBS

EC2 인스턴스(EC2 instance)는 플랫폼에서 웹 앱을 실행하도록 구성된 Amazon Elastic Compute Cloud(Amazon EC2) 가상 머신입니다.

Amazon Aurora는 저렴한 비용으로 데이터베이스 기능을 제공하는 MySQL과 호환되는 상용 데이터베이스 엔진입니다.

Amazon Aurora - Amazon Aurora

수명 주기 동안 LTS 마이너 버전을 계속 사용하려면 해당 DB 인스턴스에 대해 [자동 마이너 버전 업그레이드(Auto minor version upgrade)]를 비활성화합니다. LTS 마이너 버전에서 DB 클러스터를 자동으로

docs.aws.amazon.com

Q.44

When a developer calls the Amazon CloudWatch API, he receives HTTP 400: ThrottlingException errors sporadically. When a call is not successful, no data is obtained.

Which best practice should be implemented first in order to remedy this issue?

- A. Contact AWS Support for a limit increase.

- B. Use the AWS CLI to get the metrics

- C. Analyze the applications and remove the API call

- D. Retry the call with exponential backoff

개발자가 Amazon CloudWatch API를 호출할 때 HTTP 400: ThrottlingException 오류를 산발적으로 수신합니다. 호출이 실패하면 데이터가 수집되지 않습니다.

이 문제를 해결하기 위해 가장 먼저 구현해야 할 모범 사례는 무엇입니까?

- A. 한도가 증가하려면 AWS 지원팀에 문의하십시오.

- B. AWS CLI를 사용하여 메트릭을 가져옵니다.

- C. 응용 프로그램을 분석하고 API 호출을 제거합니다.

- D. 지수 백오프로 호출 재시도

호출률을 낮추고, API스로틀링을 방지해야 합니다.

임의 지연을 사용하여 서로 다른시간에 호출하거나 지수 백오프를 사용하여 호출을 다시 시도합니다.

PutMetricData API 호출의 CloudWatch 400 스로틀링 오류 방지

PutMetricData API 호출의 CloudWatch 400 스로틀링 오류 방지

서비스 성능을 높이기 위해, CloudWatch 요청은 리전별로 각 Amazon Web Services(AWS) 계정에 대해 스로틀링됩니다. 현재 PutMetricData API 요청 할당량은 CloudWatch 서비스 할당량을 참조하십시오. 참고: AWS 리

aws.amazon.com

Q.45

A developer is in the process of developing an event handling system. The developer established a normal Amazon SQS queue to process messages asynchronously. According to quality assurance testing, some events were handled several times.

What is the preferred method for preventing events from being handled multiple times?

- A. Change long polling to short polling.

- B. Use a FIFO queue and configure deduplication.

- C. Convert the standard SQS queue into a FIFO queue.

- D. Send the messages with message timers.

한 개발자가 이벤트 처리 시스템을 개발 중입니다. 개발자는 메시지를 비동기적으로 처리하기 위해 일반 아마존 SQS 대기열을 설정했다. 품질보증 테스트 결과 일부 이벤트는 여러 차례 처리됐다.

이벤트가 여러 번 처리되지 않도록 하려면 어떤 방법을 사용하는 것이 좋습니까?

- A. 긴 폴링을 짧은 폴링으로 변경합니다.

- B. FIFO 대기열을 사용하고 중복 제거를 구성합니다.

- C. 표준 SQS 큐를 FIFO 큐로 변환합니다.

- D. 메시지 타이머를 사용하여 메시지를 보냅니다.

FIFO 대기열은 작업 및 이벤트 순서가 중요하거나 중복 항목이 허용되지 않는 경우 유용합니다. 정확히 1회 처리를 제공하지만 초당 트랜잭션 (TPS) 수가 제한적입니다.

Amazon SQS FIFO (선입선출) 대기열 - Amazon Simple Queue Service

Amazon SQS FIFO (선입선출) 대기열 - Amazon Simple Queue Service

FIFO 대기열의 이름은.fifo접미사 접미사는 문자 80개의 대기열 이름 할당량에 포함됩니다. 대기열이 있는지 확인하려면FIFO대기열 이름이 접미사로 끝나는지 확인할 수 있습니다.

docs.aws.amazon.com

Q.46

Where in the application source bundle should an Elastic Beanstalk configuration file called healthcheckur1.config be placed?

- A. In the root of the application

- B. In the bin folder

- C. In healthcheckur1.config.ebextension under root

- D. In the .ebextensions folder

애플리케이션 소스 번들에서 healthcheckur1.config라는 Elastic Beanstalk 구성 파일을 어디에 배치해야 합니까?

- A. 응용 프로그램의 루트

- B. bin 폴더에서

- C. root 아래의 healthcheckur1.config.ebextension에서

- D. .ebextensions 폴더에서

웹 애플리케이션의 소스 코드에 AWS Elastic Beanstalk 구성 파일을 추가하여 환경을 구성하고 환경에 있는 AWS 리소스를 사용자 지정할 수 있습니다. 구성 파일은 .config 파일 확장명을 사용하는 YAML이나 JSON 형식 문서로,

.ebextensions 폴더에 놓고 애플리케이션 소스 번들로 배포합니다.

구성 파일(.ebextensions)을 사용하여 고급 환경 사용자 지정 - AWS Elastic Beanstalk

구성 파일(.ebextensions)을 사용하여 고급 환경 사용자 지정 - AWS Elastic Beanstalk

새 구성 파일을 개발하거나 테스트할 때 기본 애플리케이션을 실행하는 정리된 환경을 시작하고 여기에 배포합니다. 구성 파일의 형식을 잘못 지정하면 새 환경 시작이 복구 불가능하게 실패할

docs.aws.amazon.com

Q.47

Before data is sent to a downstream service, it is processed by a Lambda function. Each byte of data is around 1MB in size. Following a security assessment, the function must now encrypt data prior to transmitting it downstream.

Which API call is necessary to encrypt the data?

- A. Pass the data to the KMS ReEncrvpt API for encryption.

- B. Use the KMS GenerateDataKey API to get an encryption key.

- C. Use the KMS GenerateDataKeyWithoutPlainText API to get an encryption key.

- D. Pass the data to KMS as part of the Encrypt API for encryption.

다운스트림 서비스로 데이터를 전송하기 전에 람다 함수를 통해 데이터를 처리합니다. 데이터의 각 바이트 크기는 약 1MB입니다. 보안 평가 후 다운스트림을 전송하기 전에 데이터를 암호화해야 합니다.

데이터를 암호화하기 위해 필요한 API 호출은 무엇입니까?

- A. 암호화를 위해 데이터를 KMS ReEncrpt API로 전달합니다.

- B. KMS GenerateDataKey API를 사용하여 암호화 키를 가져옵니다.

- C. KMS GenerateDataKeyWithoutPlainText API를 사용하여 암호화 키를 가져옵니다.

- D. 암호화 API의 일부로 데이터를 KMS에 전달합니다.

AWS KMS는 데이터 키를 암호화하고 해독하도록 설계되었습니다.

GenerateDataKey 및 GenerateDataKeyWithoutPlaintext 작업은 암호화된 데이터 키를 반환합니다.

GenerateDataKeyWithoutPlaintext는 데이터 키의 일반 텍스트 복사본을 반환하지 않습니다.

데이터 키 암호화 및 해독 - AWS Key Management Service

데이터 키 암호화 및 해독 - AWS Key Management Service

이 페이지에 작업이 필요하다는 점을 알려 주셔서 감사합니다. 실망시켜 드려 죄송합니다. 잠깐 시간을 내어 설명서를 향상시킬 수 있는 방법에 대해 말씀해 주십시오.

docs.aws.amazon.com

Q.48

A corporation uses Amazon API Gateway and the API Gateway native API key validation to maintain a REST service. Users can now join up for the service through a new registration website that was recently developed by the corporation. The registration page uses CreateApiKey to generate a new API key and sends it to the user. The user receives a 403 Forbidden error when attempting to call the API with this key. Existing API users are unaffected and can continue to utilize it.

What changes to the code will allow these additional users to access the API?

- A. The createDeployment method must be called so the API can be redeployed to include the newly created API key.

- B. The updateAuthorizer method must be called to update the API's authorizer to include the newly created API key.

- C. The importApiKeys method must be called to import all newly created API keys into the current stage of the API.

- D. The createUsagePlanKey method must be called to associate the newly created API key with the correct usage plan.

회사는 Amazon API Gateway 및 API Gateway 기본 API 키 검증을 사용하여 REST 서비스를 유지합니다. 이용자들은 이제 그 회사가 최근에 개발한 새로운 등록 웹사이트를 통해 그 서비스에 가입할 수 있다. 등록 페이지에서 CreateApiKey를 사용하여 새 API 키를 생성하고 사용자에게 전송합니다. 이 키로 API를 호출하려고 하면 403 금지 오류가 발생합니다. 기존 API 사용자는 영향을 받지 않으며 계속 활용할 수 있습니다.

이러한 추가 사용자가 API에 액세스할 수 있게 하는 코드의 변경 사항은 무엇입니까?

- A. 새로 생성된 API 키를 포함하도록 API를 다시 배포할 수 있도록 createDeployment 메서드를 호출해야 합니다.

- B. 업데이트새로 만든 API 키를 포함하도록 API의 인증자를 업데이트하려면 Authorizer 메서드를 호출해야 합니다.

- C. 새로 만든 모든 API 키를 API의 현재 단계로 가져오려면 importApiKeys 메서드를 호출해야 합니다.

- D. 새로 생성된 API 키를 올바른 사용 계획과 연결하려면 createUsagePlanKey 메서드를 호출해야 합니다.

API 키 소스 선택 - Amazon API Gateway

API 키 소스 선택 - Amazon API Gateway

API 키 소스 선택 사용량 계획을 API와 연결하고 API 메서드에서 API 키를 활성화할 때 API에 수신되는 모든 요청에는 API 키가 포함되어야 합니다. API Gateway는 이 키를 읽고 사용량 계획에 있는 키와

docs.aws.amazon.com

Q.49

Multiple EC2 instances are used to execute an application behind an ELB.

Where is the ideal place to store session data so that it can be consistently delivered over numerous requests?

- A. Write data to Amazon ElastiCache

- B. Write data to Amazon Elastic Block Store.

- C. Write data to Amazon EC2 Instance Store.

- D. Write data to the root filesystem.

ELB 뒤에서 애플리케이션을 실행하기 위해 여러 EC2 인스턴스가 사용됩니다.

세션 데이터를 저장하여 수많은 요청에 대해 지속적으로 제공할 수 있는 이상적인 장소는 어디입니까?

- A. Amazon ElastiCache에 데이터 쓰기

- B. Amazon Elastic Block Store에 데이터를 씁니다.

- C. Amazon EC2 인스턴스 저장소에 데이터를 씁니다.

- D. 루트 파일 시스템에 데이터를 씁니다.

Session Management

In order to address scalability and to provide a shared data storage for sessions that can be accessible from any individual web server, you can abstract the HTTP sessions from the web servers themselves. A common solution to for this is to leverage an In-

aws.amazon.com

Q.50

A development team is now supporting an application that saves cumulative gaming outcomes in an in-memory store. A database is used to keep individual outcomes. The team must employ automated scaling as part of the migration to AWS. The team is aware that this will result in uneven outcomes.

Where should the team keep these gathered game outcomes in order to achieve the highest level of consistency without jeopardizing performance?

- A. Amazon S3

- B. Amazon RDS

- C. Amazon ElastiCache

- D. Amazon Kinesis

개발 팀은 현재 인메모리 스토어에서 누적된 게임 결과를 저장하는 애플리케이션을 지원하고 있다. 데이터베이스는 개별 결과를 보관하는 데 사용됩니다. 팀은 AWS로의 마이그레이션의 일부로 자동 확장을 사용해야 합니다. 팀은 이것이 불균일한 결과를 초래할 것이라는 것을 알고 있다.

팀은 성과를 위태롭게 하지 않고 최고 수준의 일관성을 달성하기 위해 수집된 게임 결과를 어디에 보관해야 합니까?

- A. 아마존 S3

- B. Amazon RDS

- C. 아마존 엘라스티캐시

- D. 아마존 키네시스

일반적인 ElastiCache 사용 사례 및 ElastiCache 활용 방법 - Amazon ElastiCache

일반적인 ElastiCache 사용 사례 및 ElastiCache 활용 방법 - Amazon ElastiCache

이 페이지에 작업이 필요하다는 점을 알려 주셔서 감사합니다. 실망시켜 드려 죄송합니다. 잠깐 시간을 내어 설명서를 향상시킬 수 있는 방법에 대해 말씀해 주십시오.

docs.aws.amazon.com

Q.51

A developer is developing an application for Amazon EC2 instances. To read and write records, the application must establish a connection to an Amazon DynamoDB database. The security staff must change access keys on a regular basis.

Which technique will meet these criteria?

- A. Create an IAM role with read and write access to the DynamoDB table. Generate access keys for the user and store the access keys in the application as environment variables.

- B. Create an IAM user with read and write access to the DynamoDB table. Store the user name and password in the application and generate access keys using an AWS SDK.

- C. Create an IAM role, configure read and write access for the DynamoDB table, and attach to the EC2 instances.

- D. Create an IAM user with read and write access to the DynamoDB table. Generate access keys for the user and store the access keys in the application as a credentials file.

한 개발자가 아마존 EC2 인스턴스용 애플리케이션을 개발하고 있다. 레코드를 읽고 쓰려면 응용 프로그램이 Amazon DynamoDB 데이터베이스에 대한 연결을 설정해야 합니다. 보안 담당자는 정기적으로 액세스 키를 변경해야 합니다.

어떤 기법이 이러한 기준을 충족할 것인가?

- A. DynamoDB 테이블에 대한 읽기 및 쓰기 권한이 있는 IAM 역할을 만듭니다. 사용자에 대한 액세스 키를 생성하고 액세스 키를 환경 변수로 응용 프로그램에 저장합니다.

- B. DynamoDB 테이블에 대한 읽기 및 쓰기 권한을 가진 IAM 사용자를 만듭니다. 응용 프로그램에 사용자 이름과 암호를 저장하고 AWS SDK를 사용하여 액세스 키를 생성합니다.

- C. IAM 역할을 만들고 DynamoDB 테이블에 대한 읽기 및 쓰기 액세스를 구성한 다음 EC2 인스턴스에 연결합니다.

- D. DynamoDB 테이블에 대한 읽기 및 쓰기 권한을 가진 IAM 사용자를 만듭니다. 사용자에 대한 액세스 키를 생성하고 액세스 키를 인증 정보 파일로 응용 프로그램에 저장합니다.

DynamoDB 예방 보안 모범 사례 - Amazon DynamoDB

DynamoDB 예방 보안 모범 사례 - Amazon DynamoDB

이 페이지에 작업이 필요하다는 점을 알려 주셔서 감사합니다. 실망시켜 드려 죄송합니다. 잠깐 시간을 내어 설명서를 향상시킬 수 있는 방법에 대해 말씀해 주십시오.

docs.aws.amazon.com

Q.52

A developer is using Amazon S3 to store critical documents that need encryption at rest. At the very least, the encryption keys must be cycled yearly.

What is the simplest method for doing this?

- A. Encrypt the data before sending it to Amazon S3

- B. Import a custom key into AWS KMS with annual rotation enabled

- C. Use AWS KMS with automatic key rotation

- D. Export a key from AWS KMS to encrypt the data

한 개발자는 아마존 S3를 사용하여 암호화가 필요한 중요 문서를 저장한다. 최소한 암호화 키는 1년에 한 번씩 사이클링해야 합니다.

이것을 하는 가장 간단한 방법은 무엇입니까?

- A. 데이터를 Amazon S3로 보내기 전에 암호화하십시오.

- B. 연간 회전이 활성화된 사용자 지정 키를 AWS KMS로 가져오기

- C. 자동 키 회전과 함께 AWS KMS 사용

- D. AWS KMS에서 데이터 암호화를 위한 키 내보내기

AWS KMS 개념 - AWS Key Management Service

AWS KMS 개념 - AWS Key Management Service

AWS KMS에서는 고객 마스터 키(CMK)라는 용어가 AWS KMS key와 KMS 키로 바뀌었습니다. 단, 개념은 바뀌지 않았습니다. 호환성에 영향을 미치는 변경 사항이 발생하지 않도록 AWS KMS에서는 이 용어의 일

docs.aws.amazon.com

Q.53

A business delivers APIs as a service and binds all of its users to a service level agreement (SLA).

What should the organization do to ensure compliance with each SLA?

- A. Enable throttling limits for each method in Amazon API Gateway

- B. Create a usage plan for each user and request API keys to access the APIs

- C. Enable API rate limiting in Amazon Cognito for each user

- D. Enable default throttling limits for each stage after deploying the APIs

기업은 API를 서비스로 제공하고 모든 사용자를 SLA(Service Level Agreement)에 구속합니다.

조직은 각 SLA를 준수하기 위해 무엇을 해야 합니까?

- A. Amazon API Gateway에서 각 메서드에 대해 조절 제한 사용

- B. 각 사용자에 대한 사용 계획을 작성하고 API에 액세스할 수 있는 API 키를 요청합니다.

- C. 각 사용자에 대해 Amazon Cognito에서 API 속도 제한 사용

- D. API 배포 후 각 단계에 대해 기본 조절 제한 사용

Amazon API Gateway Service Level Agreement

This Amazon API Gateway Service Level Agreement (“SLA”) is a policy governing the use of Amazon API Gateway (“API Gateway”) and applies separately to each account using API Gateway. In the event of a conflict between the terms of this SLA and the t

aws.amazon.com

Q.54

A developer created a static website hosted on Amazon S3 that uses Amazon API Gateway and AWS Lambda to conduct web service queries. The site is now displaying an error message that reads as follows:

The requested resource does not have an Access-Control-Allow-Origin header. As a result, origin is denied access.

What is the Developer's responsibility in resolving this issue?

- A. Enable cross-origin resource sharing (CORS) on the S3 bucket.

- B. Enable cross-origin resource sharing (CORS) for the method in API Gateway

- C. Add the Access-Control-Request-Method header to the request

- D. Add the Access-Control-Request-Headers header to the request

한 개발자는 아마존 API 게이트웨이와 AWS 람다를 사용하여 웹 서비스 쿼리를 수행하는 아마존 S3에 호스팅된 정적 웹 사이트를 만들었다. 이제 사이트에 다음과 같은 오류 메시지가 표시됩니다.

요청한 리소스에 액세스 제어 허용 오리진 헤더가 없습니다. 따라서 오리진 액세스가 거부됩니다.

이 문제를 해결하는 데 있어 개발자의 책임은 무엇입니까?

- A. S3 버킷에서 CORS(Cross-Origin Resource Sharing)를 사용하도록 설정합니다.

- B. API Gateway에서 메서드에 대한 CORS(cross-origin resource sharing) 사용

- C. 요청에 Access-Control-Request-Method 머리글 추가

- D. 요청에 Access-Control-Request-Headers 머리글 추가

API Gateway 콘솔을 사용하여 리소스에서 CORS 활성화 - Amazon API Gateway

API Gateway 콘솔을 사용하여 리소스에서 CORS 활성화 - Amazon API Gateway

상기 지침을 프록시 통합에서 ANY 메서드에 적용할 때 어떤 적용 가능한 CORS도 설정하지 않습니다. 대신 백엔드에서 해당 CORS 헤더를 반환해야 합니다(예: Access-Control-Allow-Origin).

docs.aws.amazon.com

Q.55

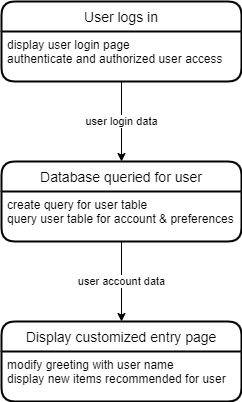

Returning consumers may log in to see personalized web pages on an e-commerce site. The process is shown below:

On EC2 instances, an application is executing. The database that records user accounts and preferences is hosted on Amazon RDS. While waiting for the login stage to finish, the website freezes or loads slowly. The remainder of the site's components are properly optimized.

Which of the following strategies will effectively fix this situation? (Select two.)

- A. Implement the user login page as an asynchronous Lambda function.

- B. Use Amazon ElastiCache for MemCached to cache user data.

- C. Use an Amazon Application Load Balancer to load balance the traffic to the website.

- D. Call the database asynchronously so the code can continue executing.

- E. Batch login requests from hundreds of users together as a single read request to the database.

돌아오는 소비자는 전자 상거래 사이트에서 개인화된 웹 페이지를 보기 위해 로그인할 수 있다. 프로세스는 다음과 같습니다.

EC2 인스턴스에서 응용 프로그램이 실행 중입니다. 사용자 계정 및 기본 설정을 기록하는 데이터베이스는 Amazon RDS에서 호스팅되며, 로그인 단계가 끝나기를 기다리는 동안 웹 사이트가 동결되거나 로딩 속도가 느려집니다. 사이트의 나머지 구성 요소는 적절하게 최적화되어 있습니다.

다음 중 이 상황을 효과적으로 해결할 수 있는 전략은 무엇입니까? (2개 선택)

- A. 사용자 로그인 페이지를 비동기 람다 함수로 구현합니다.

- B. Amazon ElastiCache for MemCached를 사용하여 사용자 데이터를 캐시합니다.

- C. Amazon 애플리케이션 로드 밸런서를 사용하여 웹 사이트에 대한 트래픽 로드 밸런싱을 수행합니다.

- D. 코드가 계속 실행될 수 있도록 데이터베이스를 비동기식으로 호출합니다.

- E. 수백 명의 사용자가 보낸 로그인 요청을 데이터베이스에 대한 단일 읽기 요청으로 일괄 처리합니다.

비동기식 호출 관리 - AWS SDK for JavaScript

비동기식 호출 관리 - AWS SDK for JavaScript

이 페이지에 작업이 필요하다는 점을 알려 주셔서 감사합니다. 실망시켜 드려 죄송합니다. 잠깐 시간을 내어 설명서를 향상시킬 수 있는 방법에 대해 말씀해 주십시오.

docs.aws.amazon.com

Q.56

A vast number of tiny messages are ingested by an application and stored in a database. AWS Lambda is used to power the application. A development team is making adjustments to the processing logic of the program. Each message is processing more than 15 minutes in testing. The team is worried that the present backend will fail to function properly.

Which improvements to the backend system should be implemented to guarantee that each message is treated in the most scalable manner possible?

- A. Add the messages to an Amazon SQS queue. Set up and Amazon EC2 instance to poll the queue and process messages as they arrive.

- B. Add the messages to an Amazon SQS queue. Set up Amazon EC2 instances in an Auto Scaling group to poll the queue and process the messages as they arrive.

- C. Create a support ticket to increase the Lambda timeout to 60 minutes to allow for increased processing time.

- D. Change the application to directly insert the body of the message into an Amazon RDS database.

방대한 수의 작은 메시지가 응용 프로그램에 의해 수집되고 데이터베이스에 저장됩니다. AWS Lambda는 응용 프로그램에 전원을 공급하는 데 사용됩니다. 개발팀은 프로그램의 처리 논리를 조정하고 있다. 각 메시지가 테스트에서 15분 이상 처리되고 있습니다. 그 팀은 현재의 백엔드가 제대로 작동하지 않을까 걱정한다.

각 메시지가 가장 확장 가능한 방식으로 처리되도록 보장하기 위해 백엔드 시스템에 대해 어떤 개선이 구현되어야 합니까?

- A. 메시지를 Amazon SQS 대기열에 추가합니다. 및 Amazon EC2 인스턴스를 설정하여 큐를 폴링하고 메시지가 도착하면 처리합니다.

- B. 메시지를 Amazon SQS 대기열에 추가합니다. 자동 스케일링 그룹에 Amazon EC2 인스턴스를 설정하여 대기열을 폴링하고 메시지가 도착할 때 처리합니다.

- C. 처리 시간을 늘리기 위해 람다 시간 초과를 60분으로 늘리기 위해 지원 티켓을 만듭니다.

- D. 응용 프로그램을 변경하여 메시지 본문을 Amazon RDS 데이터베이스에 직접 삽입합니다.

Lambda 할당량 - AWS Lambda

Lambda 문서, 로그 메시지 및 콘솔은 약어 MB(MiB 대신)를 사용하여 1,024KB를 나타냅니다.

docs.aws.amazon.com

Q.57

An application developer is tasked with integrating Amazon CloudWatch into an on-premises environment.

According to AWS security best practices, how should the application use CloudWatch?

- A. Configure AWS credentials in the application server with an AWS SDK

- B. Implement and proxy API-calls through an EC2 instance

- C. Store IAM credentials in the source code to enable access

- D. Add the application server SSH-key to AWS

애플리케이션 개발자는 Amazon CloudWatch를 사내 환경에 통합해야 합니다.

AWS 보안 모범 사례에 따르면 애플리케이션이 CloudWatch를 어떻게 사용해야 합니까?

- A. AWS SDK를 사용하여 애플리케이션 서버에서 AWS 인증 정보 구성

- B. EC2 인스턴스를 통한 API 호출 구현 및 프록시

- C. 소스 코드에 IAM 자격 증명을 저장하여 액세스를 활성화합니다.

- D. 애플리케이션 서버 SSH 키를 AWS에 추가합니다.

온프레미스 서버에 CloudWatch 에이전트 설치 - Amazon CloudWatch

온프레미스 서버에 CloudWatch 에이전트 설치 - Amazon CloudWatch

이 페이지에 작업이 필요하다는 점을 알려 주셔서 감사합니다. 실망시켜 드려 죄송합니다. 잠깐 시간을 내어 설명서를 향상시킬 수 있는 방법에 대해 말씀해 주십시오.

docs.aws.amazon.com

Q.58

A developer attempts to use the command aws configure after installing the AWS CLI and gets the following error:

aws: command not found Error: aws: command not found

Which of the following is the most probable source of this error?

- A. The aws executable is not in the PATH environment variable.

- B. Access to the aws executable has been denied to the installer.

- C. Incorrect AWS credentials were provided.

- D. The aws script does not have an executable file mode.

AWS CLI를 설치한 후 개발자가 aWS configure 명령을 사용하려고 하면 다음 오류가 발생합니다.

aws: 명령을 찾을 수 없음 오류: aws: 명령을 찾을 수 없습니다.

다음 중 이 오류의 가장 가능성이 높은 원인은 무엇입니까?

- A. aWS 실행 파일이 PATH 환경 변수에 없습니다.

- B. aWS 실행 파일에 대한 액세스가 설치 프로그램에 대해 거부되었습니다.

- C. 잘못된 AWS 자격 증명을 제공했습니다.

- D. aWS 스크립트에 실행 파일 모드가 없습니다.

AWS CLI 오류 문제 해결 - AWS Command Line Interface

AWS CLI 오류 문제 해결 - AWS Command Line Interface

AWS CLI 오류 문제 해결 일반: 최신 버전의 AWS CLI를 실행 중인지 확인합니다. 명령이 존재하지 않는다는 오류가 발생하거나 설명서에서 사용 가능하다고 나열된 파라미터를 인식하지 못하는 오류

docs.aws.amazon.com

Q.59

A business utilizes AWS CodeBuild and AWS CodeCommit to implement a continuous build process. Developers routinely submit code throughout the development period, resulting in large build failures. The firm is looking for a solution that would generate code prior to developers pushing it to the main branch.

Which option best fits these criteria in terms of cost-effectiveness?

- A. Configure am Amazon EC2 instance with the CodeBuild agent to build the code.

- B. Configure CodeBuild jobs on AWS for each branch build process.

- C. Configure the CodeBuild agent to build the code in the local system.

- D. Configure a Jenkins plugin for CodeBuild to run the code build process

회사는 AWS CodeBuild와 AWS CodeCommit을 활용하여 지속적인 빌드 프로세스를 구현합니다. 개발자는 개발 기간 내내 정기적으로 코드를 제출하여 대규모 빌드 실패를 초래합니다. 그 회사는 개발자들이 그것을 본사로 밀어넣기 전에 코드를 생성할 해결책을 찾고 있다.

비용 효율성 측면에서 이러한 기준에 가장 적합한 옵션은 무엇입니까?

- A. 코드를 빌드할 CodeBuild 에이전트를 사용하여 Amazon EC2 인스턴스를 구성합니다.

- B. 각 분기 빌드 프로세스에 대해 AWS에서 CodeBuild 작업을 구성합니다.

- C. 로컬 시스템에서 코드를 빌드하도록 CodeBuild 에이전트를 구성합니다.

- D. 코드 빌드 프로세스를 실행할 CodeBuild용 Jenkins 플러그인 구성

Run builds locally with the AWS CodeBuild agent - AWS CodeBuild

Run builds locally with the AWS CodeBuild agent - AWS CodeBuild

Thanks for letting us know this page needs work. We're sorry we let you down. If you've got a moment, please tell us how we can make the documentation better.

docs.aws.amazon.com

Q.60

In an Amazon DynamoDB database, a game holds user game data. Individual users should not have access to the gaming data of other players.

How is this possible?

- A. Encrypt the game data with individual user keys.

- B. Restrict access to specific items based on certain primary key values.

- C. Stage data in SQS queues to inject metadata before accessing DynamoDB.

- D. Read records from DynamoDB and discard irrelevant data client-side.

아마존 다이너모DB 데이터베이스에서 게임은 사용자 게임 데이터를 보유하고 있다. 개인 사용자는 다른 플레이어의 게임 데이터에 액세스해서는 안 됩니다.

이것이 어떻게 가능한 걸까요?

- A. 개별 사용자 키로 게임 데이터를 암호화합니다.

- B. 특정 기본 키 값을 기준으로 특정 항목에 대한 액세스를 제한합니다.

- C. DynamoDB에 액세스하기 전에 데이터를 SQS 대기열에서 스테이징하여 메타데이터를 주입합니다.

- D. DynamoDB에서 레코드를 읽고 관련 없는 데이터를 클라이언트 측에서 삭제합니다.

IAM 정책 조건을 사용하여 세부적인 액세스 제어 구현 - Amazon DynamoDB

IAM 정책 조건을 사용하여 세부적인 액세스 제어 구현 - Amazon DynamoDB

dynamodb:Attributes를 사용하는 경우 정책에 나열된 테이블 및 보조 인덱스에 대한 모든 기본 키 및 인덱스 키 속성의 이름을 지정해야 합니다. 그렇지 않으면, DynamoDB에서 이러한 키 속성을 사용하여

docs.aws.amazon.com

'Dev > AWS' 카테고리의 다른 글

| [AWS] EC2 Ubuntu Mysql 설치 (0) | 2022.08.03 |

|---|---|

| [AWS] EC2 시작하기(VPC, 서브넷, 인터넷게이트웨이, 라우팅 설정) (0) | 2022.08.01 |

| [AWS] [Q61~Q80]DVA-C01 AWS Certified Developer Associate (0) | 2022.06.23 |

| [AWS] [Q21~Q40]DVA-C01 AWS Certified Developer Associate (0) | 2022.06.17 |

| [AWS] [Q1~Q20]DVA-C01 AWS Certified Developer Associate (0) | 2022.06.15 |